什么是 RAG(检索增强生成)?

近年来,大型语言模型(LLMs)如 GPT 系列取得了惊人的进步,能够生成流畅、连贯且富有创造性的文本。然而,它们也存在一些固有的局限性,例如:

- 知识截止日期 (Knowledge Cutoff):模型只知道训练时接触过的信息,无法获取实时或最新的知识。

- 幻觉 (Hallucination):有时会编造看似合理但不正确或无事实依据的信息。

- 领域特定知识缺乏:对于未包含在训练数据中的私有或特定领域知识,表现不佳。

为了解决这些问题,检索增强生成 (Retrieval-Augmented Generation, RAG) 技术应运而生。

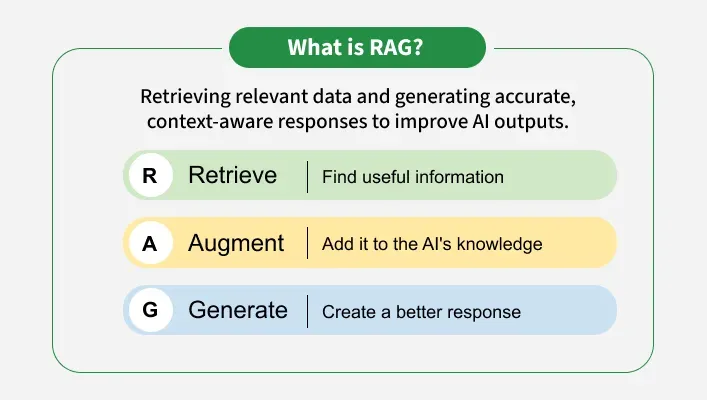

RAG 是什么?

RAG 是一种结合了信息检索 (Information Retrieval) 系统和大型语言模型生成能力的技术框架。

其核心思想是:在让 LLM 生成回答之前,先从一个外部知识库(如文档集合、数据库、网页等)中检索出与用户提问相关的最新或特定信息,然后将这些检索到的信息作为上下文 (Context),连同用户的原始问题一起提供给 LLM,让 LLM 基于这些“增强”过的信息来生成最终的回答。

RAG 的工作流程

一个典型的 RAG 系统通常包含以下步骤:

检索 (Retrieve):

- 当用户提出一个问题或指令 (Query/Prompt) 时,系统首先使用这个查询去搜索一个外部的知识库。

- 这个知识库通常是预先处理好的文档集合,可能存储在向量数据库 (Vector Database) 中,通过计算查询与文档之间的语义相似度(例如使用 Embedding 技术)来找到最相关的几段文本或文档片段。

增强 (Augment):

- 将上一步检索到的相关信息(即上下文 Context)与用户的原始查询结合起来,形成一个增强后的提示 (Augmented Prompt)。

- 这个增强后的提示包含了原始问题的意图以及相关的背景知识或事实依据。

生成 (Generate):

- 将这个增强后的提示输入给大型语言模型 (LLM)。

- LLM 基于其强大的理解和生成能力,同时参考提供的上下文信息,生成一个更加准确、可靠且与特定知识相关的回答。

可以将其想象成一个“开卷考试”的过程: LLM(学生)在回答问题前,被允许先去查找相关的参考资料(检索到的上下文),然后再根据这些资料来组织答案。

为什么使用 RAG? RAG 的优势

相比于直接使用 LLM 或对其进行微调 (Fine-tuning),RAG 提供了诸多优势:

- 提高事实准确性,减少幻觉:通过引入外部的、可验证的信息源,显著降低了 LLM “凭空捏造”信息的可能性。

- 访问最新知识:可以轻松地通过更新外部知识库来让模型获取最新信息,无需重新训练庞大的 LLM。

- 利用特定领域/私有知识:能够让 LLM 回答关于特定数据集(如公司内部文档、特定领域的专业知识库)的问题,而无需将这些私有数据用于模型训练。

- 更具成本效益:相比于为特定知识对 LLM 进行大规模微调或重新训练,维护和更新外部知识库通常成本更低、效率更高。

- 可解释性与可追溯性:可以更容易地追踪到答案所依据的信息来源(检索到的文档),提高了系统的透明度。

总结

RAG 是一种强大的技术,它有效地将大型语言模型的生成能力与外部知识库的广度和实时性结合起来,显著提升了 AI 应用在处理需要特定、最新或准确信息场景下的表现。它已成为构建更可靠、更智能的问答系统、聊天机器人和其他知识密集型 AI 应用的关键技术之一。